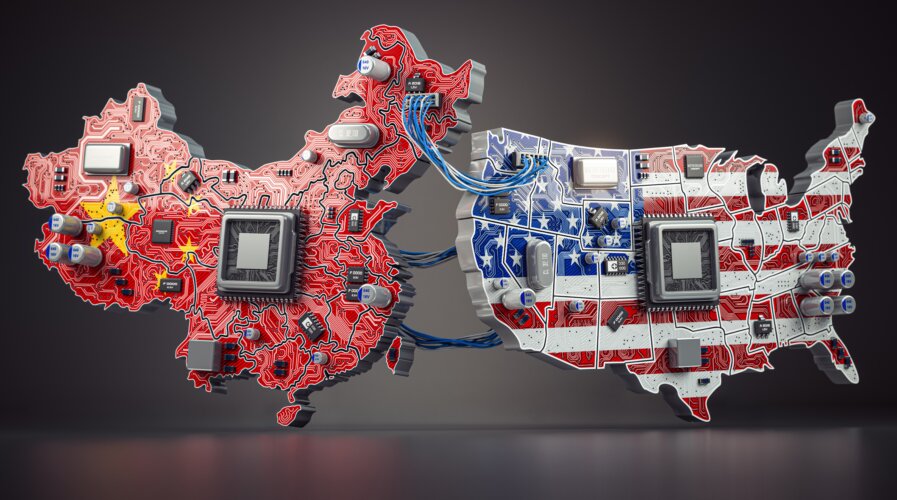

Os controles de exportação dos EUA sobre semicondutores avançados foram projetados para retardar o progresso da China na área de inteligência artificial (IA), mas podem ter inadvertidamente estimulado a inovação. Incapazes de depender apenas do hardware mais recente, empresas como a DeepSeek, sediada em Hangzhou, foram forçadas a encontrar soluções criativas para fazer mais com menos.

Além disso, a China está adotando uma estratégia de código aberto e emergindo como um dos maiores provedores de modelos de IA poderosos e totalmente abertos no mundo.

Este mês, a DeepSeek lançou seu modelo R1, utilizando técnicas avançadas, como aprendizado por reforço puro, para criar um modelo que não apenas está entre os mais formidáveis do mundo, mas também é totalmente de código aberto, disponível para qualquer pessoa no mundo examinar, modificar e construir sobre ele.

O DeepSeek-R1 demonstra que a China não está fora da corrida da IA e, de fato, pode ainda dominar o desenvolvimento global de IA com sua surpreendente estratégia de código aberto. Ao disponibilizar modelos competitivos em código aberto, as empresas chinesas podem aumentar sua influência global e potencialmente moldar os padrões e práticas internacionais de IA. Projetos de código aberto também atraem talentos e recursos globais para contribuir com o desenvolvimento de IA na China. A estratégia permite ainda que a China estenda seu alcance tecnológico para países em desenvolvimento, potencialmente incorporando seus sistemas de IA – e, por extensão, seus valores e normas – na infraestrutura digital global.

O desempenho do DeepSeek-R1 é comparável aos principais modelos de raciocínio da OpenAI em uma variedade de tarefas, incluindo matemática, codificação e raciocínio complexo. Por exemplo, no benchmark de matemática AIME 2024, o DeepSeek-R1 obteve 79,8%, em comparação com 79,2% do OpenAI-o1. No benchmark MATH-500, o DeepSeek-R1 alcançou 97,3%, contra 96,4% do o1. Em tarefas de codificação, o DeepSeek-R1 atingiu o percentil 96,3 no Codeforces, enquanto o o1 atingiu o percentil 96,6 – embora seja importante notar que os resultados de benchmarks podem ser imperfeitos e não devem ser superinterpretados.

O mais notável é que a DeepSeek conseguiu alcançar isso principalmente por meio da inovação, em vez de depender dos chips de computador mais recentes. Eles introduziram o MLA (atenção latente multi-head), que reduz o uso de memória para apenas 5-13% da arquitetura MHA (atenção multi-head) comumente usada. O MHA é uma técnica amplamente utilizada em IA para processar múltiplos fluxos de informação simultaneamente, mas requer muita memória.

Para tornar seu modelo ainda mais eficiente, a DeepSeek criou a estrutura DeepSeekMoESparse. “MoE” significa Mixture-of-Experts, o que significa que o modelo usa apenas um pequeno subconjunto de seus componentes (ou “especialistas”) para cada tarefa, em vez de executar todo o sistema. A parte “esparsa” refere-se ao fato de que apenas os especialistas necessários são ativados, economizando poder de computação e reduzindo custos.

A arquitetura do DeepSeek-R1 tem 671 bilhões de parâmetros, mas apenas 37 bilhões são ativados durante a operação, demonstrando uma eficiência computacional notável. A empresa publicou um relatório técnico abrangente no GitHub, oferecendo transparência sobre a arquitetura e o processo de treinamento do modelo. O código aberto inclui a arquitetura do modelo, o pipeline de treinamento e componentes relacionados, permitindo que pesquisadores entendam e repliquem totalmente seu design.

Essas inovações permitem que o modelo da DeepSeek seja poderoso e significativamente mais acessível do que seus concorrentes. Isso já desencadeou uma guerra de preços de inferência na China, que provavelmente se espalhará para o resto do mundo.

A DeepSeek cobra uma fração do custo do OpenAI-o1 pelo uso da API. Essa redução dramática nos custos pode democratizar o acesso a capacidades avançadas de IA, permitindo que organizações menores e pesquisadores individuais aproveitem ferramentas de IA poderosas que antes estavam fora de alcance.

A DeepSeek também foi pioneira na destilação das capacidades de seu grande modelo em modelos menores e mais eficientes. Esses modelos destilados, variando de 1,5 bilhão a 70 bilhões de parâmetros, também são de código aberto, fornecendo à comunidade de pesquisa ferramentas poderosas e eficientes para inovação adicional.

Ao disponibilizar seus modelos gratuitamente para uso comercial, destilação e modificação, a DeepSeek está construindo boa vontade dentro da comunidade global de IA e potencialmente estabelecendo novos padrões para transparência no desenvolvimento de IA.

A DeepSeek foi fundada por Liang Wenfeng, 40 anos, um dos principais investidores quantitativos da China. Seu fundo de hedge, High-Flyer, financia a pesquisa de IA da empresa.

Em uma rara entrevista na China, o fundador da DeepSeek, Liang, emitiu um aviso à OpenAI: “Diante de tecnologias disruptivas, as barreiras criadas por código fechado são temporárias. Mesmo a abordagem de código fechado da OpenAI não pode impedir que outros alcancem.”

A DeepSeek faz parte de uma tendência crescente de empresas chinesas que contribuem para o movimento global de IA de código aberto, contrariando a percepção de que o setor de tecnologia da China está focado principalmente na imitação, em vez da inovação.

Em setembro, a Alibaba da China revelou mais de 100 novos modelos de IA de código aberto como parte da família Qwen 2.5, que suporta mais de 29 idiomas. O gigante de buscas chinês Baidu tem a série Ernie, a Zhipu AI tem a série GLM e a MiniMax a família MiniMax-01, todas oferecendo desempenho competitivo a custos significativamente mais baixos em comparação com os principais modelos dos EUA.

À medida que a China continua a investir e promover o desenvolvimento de IA de código aberto, enquanto navega pelos desafios impostos pelos controles de exportação, o cenário global de tecnologia provavelmente verá mais mudanças nas dinâmicas de poder, padrões de colaboração e trajetórias de inovação. O sucesso dessa estratégia pode posicionar a China como uma força líder na moldagem do futuro da IA, com consequências de longo alcance para o progresso tecnológico, a competitividade econômica e a influência geopolítica.

Por Craig S. Smith, 22 de janeiro de 2025, Forbes